목차 LangChain - Get started

- Introduction (이번 포스팅 내용)

- Installation

- Quickstart

- Security

지난 두번의 포스팅에서 OpenAI API에 대한 개요와 활용하기 위한 기본적인 방법에 대해서 알아보았습니다. 이번에는 보다 복잡하고 쓸만한 어플리케이션을 만들기 위해서 필요한 랭체인(LangChain)이라는 라이브러리에 대해서 알아보겠습니다.

일반적으로 OpenAI API를 그대로 쓰는 것 보다는 더 복잡하고 특정 업무를 처리하기 위한, 그런 어플리케이션을 만들어 사용합니다. 그도 그럴 것이 안그러면 그냥 ChatGPT의 웹을 이용하면 되겠지요. 그러나 특정 업무를 처리하기 위한, 특별한 어플리케이션을 만들려면 많은 추가적인 노력이 필요합니다. 이러한 노력을 줄여주는 라이브러리가 바로 랭체인 입니다. 이전 마지박 포스팅에서 언급한 것처럼, 살짝 특별한 대답을 위하는 경우에 가장 간단한 방법은 프롬프트 엔지니어링(Prompt Engineering)이라고 불리우는 방법으로, 사용자 입력 내용에 더하여 미리 설정된 문구를 함께 제공하는 방법이 있습니다. 이 방법은 쉽지만 한계가 많이 있습니다. 따라서 다양한 방법으로 어플리케이션의 품질을 높이는 방법이 필요한데요, 이러한 개발에 도움을 주는 라이브러리가 바로 랭체인입니다. 그래서 오늘은 먼저 랭체인의 개요에 대해서 알아보고자 합니다.

먼저, 주요 내용은 아래와 같은 페이지를 참조했음을 알립니다.

https://python.langchain.com/docs/get_started/introduction

랭체인(LangChain) 이란

LangChain 은 프레임웍입니다. 언어모델을 이용해서 어플리케이션을 개발할 때 어플리케이션이 맥락을 이해하고 추리 할 수 있도록 랭체인이 도와줍니다. 즉, 랭체인을 이용하면 언어모델을 이용한 어플리케이션이 맥락을 더 잘 이해하고, 추리를 더 잘 하게 만들 수 있습니다. 더 똑똑하게 만들 수 있습니다.

LangChain 프레임웍은 다음과 같이 4가지 파트로 구성됩니다.

- LangChain Libraries: 파이썬과 자바스크립트 라이브러리 입니다. 이것은 많은 콤포넌트들 간의 연결과 통합을 제공합니다. 예를들면, 컴포넌트들을 체인, 에이전트와 연결하 여 기본 실행 환경을 제공하고 바로 쓸수 있는 체인과 에이전트를 제공합니다.

- LangChain Templates: 다양한 종류의 작업을 위한 쉽게 배포할 수 있는 참조 아키텍처의 집합입니다.

- LangServe: LangChain을 REST API로 배포하기 위한 라이브러리 입니다.

- LangSmith: LLM 프레임웍하에서 개발되고 랭체인으로 유연하게 연결된 채인들을 디버그하고, 테스트, 평가 그리고 모니터링 할 수 있도록 기능을 제공하는 개발자 플랫폼입니다.

이러한 제품들을 이용하면 어플리케이션 라이프사이클을 단순하게 만듭니다. 개발, 제품화, 배포 등에서 활용됩니다.

- Develop: 라이브러리를 이용하여 어플리케이션을 작성하고 참조 템플릿을 이용해서 개발을 시작할 수 있습니다. 즉, 밑바닥부터 시작하는 것이 아니라 라이브러리 import, 호출 만으로 쉽게 어플리케이션을 개발 할 수 있습니다.

- Productionize: 랭스미스를 사용해서 여러분이 만든 체인을 조사, 테스트, 모니터링 할 수 있습니다. 그래서 여러분은 자신감을 가지고 지속해서 어플리케이션을 개선/배포 할 수 있습니다. 정확히 어떻게 돌아가는지 확인하고, 검증, 모니터링해서 어플리케이션의 품질을 확인할 수 있습니다.

- Deploy: 랭서브를 이용해서 어떤 체인이든지 API로 바꿀 수 있습니다. 라이브러리를 이용하여 필요한 어플리케이션을 만들면 쉽게 API화 할 수 있습니다. 즉, 쉽게 Backend를 만들 수 있습니다.

보시는 것처럼 랭체인의 파트 들이 개발 라이프 사이클에 각각 녹아 들어가서 사용됩니다.

LangChain Libraries

랭체인 패키지들의 가치있는 주요 도구들은 바로 콤포넌트들과 미리 개발된 체인들입니다.

- Components: 구성 가능한 툴과 언어모델과의 동작을 통합합니다. 여러분이 랭체인 프레임웍의 일부를 사용하던 안하던 간에, 콤포넌트들은 모듈화되어있고 사용하기 쉽습니다.

- Off-the-shelf chains: 상위 수준의 작업을 완수하기 위한 콤포넌트들의 (미리 만들어진) 빌트인 체인 집합을 말합니다.

빌트인 체인들은 랭체인을 사용한 어플리케이션의 개발 시작을 쉽게 해줍니다. 콤포넌트들은 이런 빌트인 체인들을 이용해서 기존 체인을 쉽게 수정하고 새로운 체인을 만들수 있습니다.

랭체인 라이브러리 자체는 아래 3 개의 다른 패키지들로 구성됩니다.

- langchain-core: 기본 추상화 모듈과 랭체인 표현언어(LCEL: LangChain Expression Language) 패키지입니다.

- langchain-community: 제3자들의 개발을 통합하는 패키지입니다. 패키지에는 Models I/O, Retrieval, AgentTooling 모듈이 있습니다.

- langchain: 체인, 에이전트, 그리고 어플리케이션의 인지 아키텍처를 보완하는 회수 전략(retrieval strategies)들의 패키지입니다.

Get started: 시작하기

여기에서는 어떻게 랭체인을 설치하고 여러분의 환경에 맞게 설정하고 만드는 것을 시작하는지 알려줍니다. 관련해서 별도 포스팅 예정입니다.

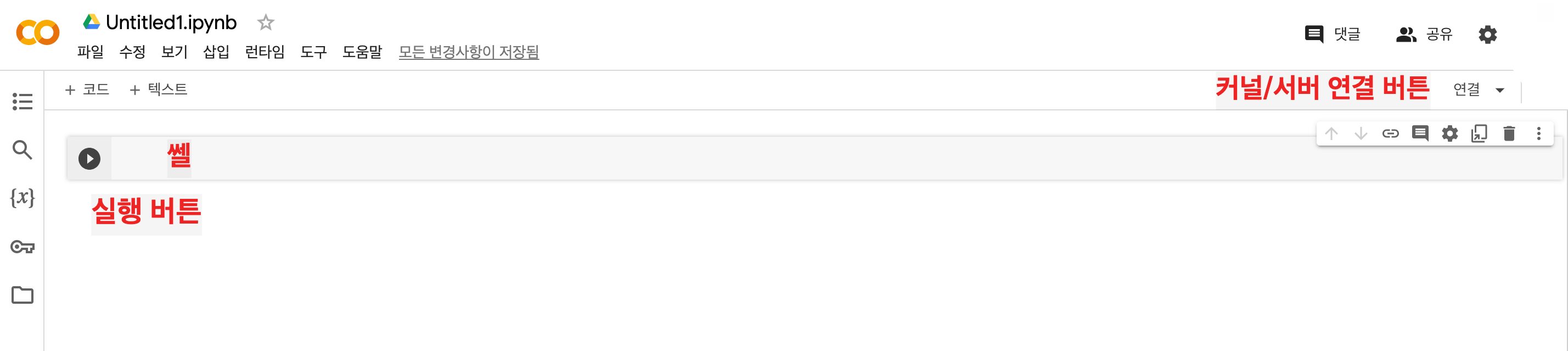

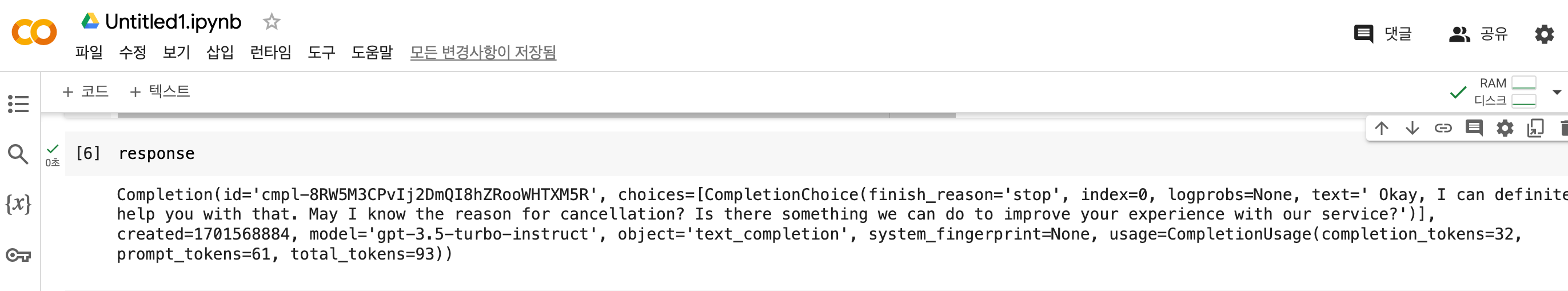

여러분이 첫번째 랭체인 어플리케이션을 만듬으로써 랭체인에 좀더 익숙해지도록 Quickstart 가이드를 따라해 보시기 바랍니다.

여러분이 보안 모범 사례 를 읽어 봄으로써 랭체인을 개발할 때 더욱 안전하게 만들어 보세요.

LangChain Expression Language (LCEL)

LCEL은 체인을 구성하기위해 선언적인 방법을 사용합니다. LCEL은 하루만에 프롬프트와 LLM의 간단한 체인부터 가장 복잡한 체인까지 코드 변경 없이 프로덕션에 프로토타입을 배포할 수 있도록 설계되었습니다. 이내용도 별도 포스팅 예정입니다. 여기서는 랭체인의 체인을 만들 떼 쉬운 방법이 (LCEL) 있구나 정도만 이해하시면 될 것 같습니다.

- Overview: LCEL과 그 장점들

- Interface: 객체들을 위한 표준 인터페이스

- How-to: LCEL의 주요 기능

- Cookbook: 공통 작업을 완료하기 위한 예시 코드

Modules

랭체인은 표준, 확장가능한 인터페이스와 통합을 위해 다음의 모듈들을 제공합니다.

Model I/O : 언어 모델과의 인터페이스 제공

Retrieval : 어플리케이션 특화 데이터와의 인터페이스 제공

Agents : 모델들이 주어진 상위 수준의 지시문을 이용하여 어떤 툴을 선택 할지를 제공하는 모듈

이러한 모듈들을 개발에 이용하여 어플리케이션을 만들게 됩니다. 따라서 어떻게 보면 개발자에게는 제일 중요한 파트라고 할 수 있습니다.

Examples, ecosystem, and resources

Use cases: 사용사례

- Document question answering

- Chatbots

- Analyzing structured data

- and much more...

Integrations: 통합 integrations.

Guides: 랭체인을 활용한 개발 모범 사례

API reference 파이썬 패키지에서 사용하기 위한 랭체인 클래스와 메소드들에 대한 문서 제공

Developer's guide

Community

아래는 내용을 좀더 자세히 설명하는 동영상 입니다.

'인공지능-기계학습 > LangChain' 카테고리의 다른 글

| LangChain Quickstart(2024년 1월 기준) (0) | 2024.01.01 |

|---|---|

| LangChain Quickstart(랭체인 기본 예시) (0) | 2023.12.29 |

| LangChain 설치 방법(Installation) (0) | 2023.12.29 |

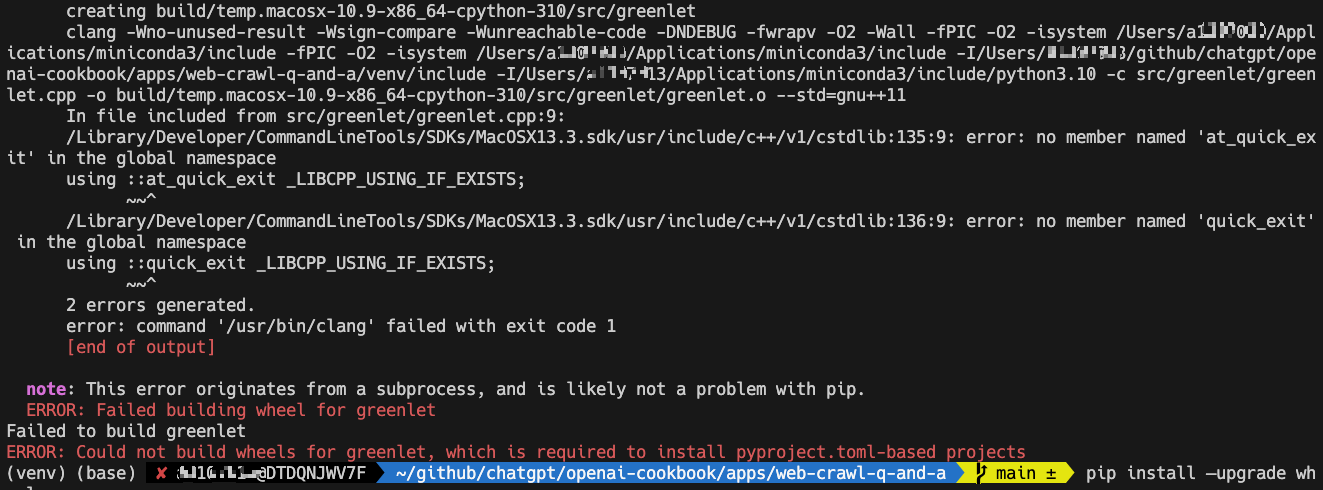

| [오류 처리] langchain 설치 (pip install langchain) 중에 아래와 같은 에러 발생 (2) | 2023.12.17 |

| [오류 처리] 잘되던 OpenAI+langchain 프로그램을, 가상 환경을 옮겨서 설치/실행하려할때 에러 처리(python pip lib 관련) (0) | 2023.12.17 |